검색 결과

"" 검색 결과: 157개의 아이템

- 대한민국 기상청도 이제는 딥러닝에 관심을 가져야 할 때?!

이상 고온 현상으로 올여름 고생들 많으셨죠. 가을이 오니 전 세계 곳곳에서 태풍으로 인한 피해가 속출하고 있습니다. 특히 미국의 경우 메이저급 허리케인 위력을 갖춘 ‘마이클’이 플로리다 반도에 상륙해 비상이 걸렸습니다. 전 세계 각국이 기후 변화를 예측하기 위해 막대한 투자를 하죠. 정부의 지원을 받는 연구 기관은 늘 최신, 최고의 슈퍼컴퓨터를 사용해 기상 예측 모델을 돌립니다. 뛰어난 인력과 강력한 슈퍼컴퓨터를 갖추고 있다고, 기상 예측을 잘할 수 있는 것은 아닙니다. 일기 예보 또 틀렸어! 이런 말을 하기는 쉽죠. 하지만 기상 예보는 정말 예측하기 어려운 분야로 손꼽힙니다. NOAA(National Centers for Environmental Information)에 따르면 세계적인 과학 기술 강국인 미국만 해도 2018년 한 해 일곱 번의 기후 관련 재난이 일어났고 이로 인한 피해 금액만 10억 달러가 넘는다고 합니다. 날씨가 변하는 패턴을 파악하고, 이를 토대로 미래를 예측한다는 것이 이처럼 어려운 것입니다. 관련해 버클리 대학교와 오크리지(Oak Ridge) 연구소가 의미 있는 연구 결과를 내놓았습니다. 연구진은 급격한 날씨 변화 패턴을 식별할 수 있는 딥러닝 시스템을 만들었습니다. 시스템 규모는 상당합니다. 2만 7,000개의 NVIDIA Tesla Tensor Core가 미국 테네시에 있는 데이터센터에서 운영 중인 서밋 슈퍼컴퓨터에 새로 장착됐습니다. 엑사스케일급 성능을 가진 시스템으로 딥러닝을 수행한 것이라 보면 됩니다. 급격한 기후 변화 시대로 접어든 대한민국도 딥러닝 기반의 기후 예측 시스템이 하루빨리 도입되었으면 하는 바람입니다. 참고로 연구진이 개발한 알고리즘과 딥러닝 모델에 대한 상세 내용은 논문을 참조 바랍니다. #NVIDIA #Tesla #TensorCore #기후변화 #슈퍼컴퓨터

- 교차로에서 차들이 어떻게 움직일지 예측하는 딥러닝 모델

방어 운전이라고 들어 보셨나요? 자동차라는 교통수단은 나만 잘 한다고 사고가 안 나지 않습니다. 교통신호, 안전 속도 등 규칙을 아무리 잘 따라도 함께 도로를 달리는 차 중에 예기치 못한 경로로 움직일 경우 사고를 피하기 어렵죠. 이런 이유로 운전자들은 늘 주변 교통 흐름을 일정 부분 예측하면서 방어 운전을 해야 합니다. 인공 지능은 자동차가 방어 운전을 하는 것도 가능하게 만들 수 있을까요? 현재 우리가 말하는 자율 자행 자동차는 운전자의 개입 없이 스스로 차를 움직이게 합니다. 대부분 예측 가능한 범위에서 아주 짧은 시간 사람의 개입 없이 자율 주행을 하는 수준인데요, 앞으로는 사람처럼 방어 운전을 하는 수준까지 발전하는 것이 시간문제로 보입니다. 최근 미국 미시건 대학과 인디아나 대학 연구진이 교차로를 오가는 차량들이 어떻게 움직일지 예측하는 딥러닝 모델에 대한 논문을 발표했습니다. 교차로는 사고 유발 지역이죠. 주황색 신호를 보고 급히 지나가려 급가속을 하다 자기 신호를 받고 움직이는 차량과 충돌하는 경우는 뉴스나 인터넷 영상을 통해 흔히 볼 수 있을 정도입니다. 이번 연구는 NVIDIA Tesla P100 GPU와 cuDNN 가속 기반 Keras와 TensorFlow 딥러닝 프레임워크를 활용해 진행되었습니다. 순환신경망(Recurrent neural network)을 적용해 트레이닝이 이루어졌고, 교차로를 오가는 2,400대의 자동차를 통해 확보한 230개의 비디오를 데이터 세트로 활용했다고 합니다. 연구진은 앞으로 도로 위를 오가는 차량 흐름, 교통 신호 등 여러 조건 속에서 상황에 대한 문맥 파악하고, 이를 토대로 복잡한 실제 도로에서 각각의 차량 움직임을 예측하는 것에 대한 쪽으로 연구를 심화할 계획이라고 합니다. #AI논문 #cuDNN #GPU #NVIDIA #Tesla #Recurrent_neural_network

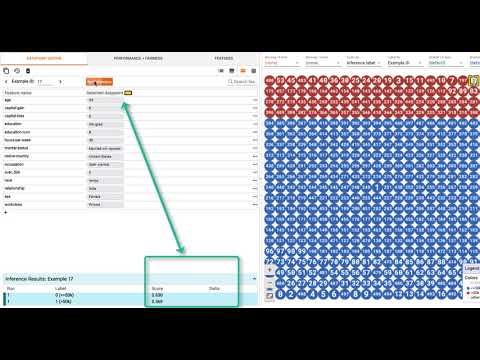

- TensorFlow 플랫폼에 추가된 What-If 툴 ~ 코드를 몰라도 모델 최적화가 가능!

구글이 대단한 도구 하나를 TensorFlow 플랫폼에 추가했습니다. 그 이름은 'What-if Tool'입니다. 이름에서 느낌이 딱 올 것입니다. 머신 러닝 모델 관련 트레이닝과 인퍼런싱 관련 분석 작업을 코드 한 줄 없이 할 수 있도록 도와주는 도구입니다. 모델 분석 작업은 코드를 잘 다룰 줄 알아야 할 수 있는 영역에 있었죠. 이를 구글이 '인간계'로 끌어내려올 것 같습니다. 이번에 소개된 도구는 모델을 평가하고, 디버깅을 하는 데 있어 개발 백그라운드가 있다면 좋겠지만, 없어도 할 수 있게 도와줍니다. What-if 도구는 TensorBoard 웹 애플리케이션의 한 부분으로 제공됩니다. 물론 오픈 소스입니다. 이 도구의 특징은 인터랙티브한 방식으로 간편하게 머신 러닝 모델을 분석할 수 있다는 것입니다. 주요 기능으로 인퍼런스(Inference) 결과를 시각적으로 보여주는 것, 데이터 포인트를 선택해 피처(Feature) 값을 자유롭게 편집할 수 있는 것, 개별 피처가 어떤 영향을 끼치는지에 대한 결과를 시각적으로 탐색하는 것 등을 제공합니다. 깃허브 소개 페이지에 가면 데모도 몇 개 올라와 있습니다. 관심 있는 분은 데모를 직접 돌려 보면 주요 특징을 직접 체험해 볼 수 있습니다. 사람의 얼굴이 나온 사진 중 웃는 모습이 담긴 것을 구분해 내는 데모를 띄워 보니 UI가 매우 직관적이라 배우는 데 큰 어려움이 없을 듯하네요. 다음 영상도 가볍게 한번 훑어보면 도움이 될 것입니다. #AI툴 #구글 #TensorFlow #Whatif도구 #AI디버깅 #Inference

- 음성과 객체를 동시에 인식하는 AI ~ 사진을 읽어 주는 인공 지능

MIT 연구팀이 사람의 음성과 객체를 동시에 인식하는 딥러닝 모델을 개발했습니다. 이 모델을 적용하면 유아 대상 컨텐츠 시장에서 흥미로운 서비스가 많이 나올 수 있을 것 같습니다. 또한, 파워포인트 등 문서를 함께 보면서 협업을 할 때 사용할 수 있는 기능으로도 유용해 보이네요. 요즘 뜨고 있는 인공 지능 스피커에도 이 기능을 좀 넣었으면 좋겠다는 생각도 듭니다. 이 모델이 하는 일은 사람이 말로 사진 속 풍경을 설명할 때 해당 객체를 사진에서 구분하는 것입니다. 연구팀은 NVIDIA TITAN Xp GPU와 cuDNN 가속 기반 PyTorch 딥러닝 프레임워크를 사용해 모델을 개발했습니다. 트레이닝을 위해 402,385개의 이미지와 캡션이 쌍으로 적용되었습니다. 이 모델의 핵심은 음성과 객체를 동시에 인식하는 것입니다. 음성 인식 관련 훈련을 위해 2,500명가량의 사람이 말하는 데이터를 사용했고, 이들이 사용한 단어 수는 대략 44,000개 정도 된다고 합니다. 이 정도면 학술 자료 아닌 이상 일상적인 스냅 사진 속에서 객체를 음성과 동시에 인식하는 데 부족함이 없어 보이네요. 더 자세한 내용은 논문과 연구팀이 공개한 코드를 참조 바랍니다. #AI논문 #음성인식 #객체인식 #NVIDIA #GPU #딥러닝

- 안경만 쓰면 나도 프로 드론 레이서가 될 수 있다!?

드론 레이싱 중계를 보면 그 속도에 한번 놀라고, 조종사의 말도 안 되는 컨트롤 실력에 도 한번 놀랍니다. 엄청난 속도로 비행을 하는 드론이 각종 장애물 코스를 충돌 없이 지나는 것을 보면 거의 본능적인 감각의 손놀림이 느껴집니다. 눈으로 드론을 쫓으며, 손으로 컨트롤러를 현란하게 조작하는 것을 보면 타고 나야 할 수 있는 일 같다는 생각이 들죠. 하지만 앞으로는 일반인도 눈짓 하나로 드론을 간단히 조정하는 시대가 올 것 같습니다. 뉴욕대학교와 펜실베이니아대학교가 공동으로 딥러닝 기반의 드론 컨트롤 시스템을 연구했습니다. 내용은 사람의 시선을 추적하는 안경을 쓰고 눈이 향하는 곳으로 드론을 조정하는 깃입니다. 다음 영상을 보시죠. 시선을 추적하는 안경을 쓴 사람의 시선이 향하는 곳으로 드론이 날아갑니다. 연구팀은 NVIDIA GeForce GTX 1080 Ti GPU와 cuDNN 가속 기반 TensorFlow 딥러닝 프레임워크 환경에서 모델을 개발했습니다. 이 모델은 안경을 통해 획득한 시선이 향하는 좌표 정보를 3D 내비게이션 탐색을 통해 정확히 짚어 내는 것을 학습합니다. 이 모델은 드론에 장착된 NVIDIA Jetson TX2 GPU 기반 플랫폼에서 추론 작업을 거듭하면서 더 정교해집니다. 대충 모델 개발과 추론 방식이 자율 주행 자동차와 비슷합니다. 자율 주행 자동차의 경우도 차량에 강력한 임베디드 GPU 기반 추론 시스템이 장착됩니다. 위 영상처럼 사용자가 카메라가 장착된 안경을 쓰면 드론의 위치가 감지되고, 사용자 시선 방향으로 드론이 움직이는 과정에 사용되는 컴퓨트 파워가 Jetson GPU라고 보면 됩니다. 안경은 드론에 장착된 이 GPU와 짝을 이뤄 동작을 합니다. 참고로 이번 연구 내용을 담은 논문은 ICRA 2019와 IEEE Robotics and Automation Letters에 제출되었습니다. #AI논문 #드론레이싱 #NVIDIA #GPU #Jetson #AI드론

- 항공 물류 자동화 시대를 여는 AI 파워

항공 물류는 노동 집약적인 업종입니다. 물류 시스템을 자동화하는 것은 가능하지만 수화물을 구분하고, 어떻게 패키징 할 것인지 결정하는 것은 사람의 몫입니다. 항공은 비용이 많이 드는 운송 수단이란 점을 떠올려 보면 사람의 판단력이 참 중요할 것 같긴 합니다. 하지만 노동 집약적인 작업은 시간과 인적 자원 투입 측면에서 늘 비효율적이죠. 더 빠르고, 효율적으로 일을 하려면 더 많은 인력을 투입할 수밖에 없습니다. 하지만 제한된 작업 공간에 인력을 무한정 늘릴 수도 없다 보니 작업 속도나 효율 개선은 뚜렷한 한계가 있습니다. 이런 한계를 인공 지능(AI) 기술로 깬 기업이 있습니다. 싱가포르의 한 연구 기관에서 SPEEDCARGO라는 토털 솔루션을 공개했습니다. 수화물을 인식하는 3D 카메라, AI 기반 패키징 의사결정 시스템, 수화물을 패키징 하는 로봇 팔을 하나의 솔루션으로 묶은 것이 SPEEDCARGO입니다. SPEEDCARGO는 노동 집약적인 항공 물류 작업장을 100% 자동화 기반으로 바꾸어 줍니다. 사람의 눈과 같이 수화물이 들어오면 크기, 무게 등을 파악합니다. 그리고 항공기 공간에 최적으로 수화물을 쌓아 운송하려면 어떻게 수화물들을 쌓아 올리면 될지를 경험 많은 현장 관리자처럼 생각하고 결정합니다. 이 모든 과정을 끝나면 로봇 팔이 수화물을 패키징 합니다. 이중 AI 기술이 접목된 것은 Cargo Mind라는 시스템입니다. 이 시스템은 NVIDIA GeForce GTX 1080 Ti GPU와 cuDNN 가속 기반 프레임워크를 기반으로 개발되었습니다. 3D 카메라 기반 수화물 인식 시스템인 Cargo Eye가 보낸 데이터를 받아 비좁은 항공 운송 공간을 최대한 활용할 수 있는 패키징 방안을 판단하고 결정합니다. 작업 방식이 어떻게 바꾸는지 다음 영상을 한번 보시죠. #AI #CaseStudy #SPEEDCARGO #NVIDIA #GeForce

- 일본 제조업계 NVIDIA 기술로 차세대 자동화 로봇 시대 연다!

NVIDIA의 Jetson AGX Xavier로 인더스트리 4.0 시대를 준비하는 제조 기업이 늘고 있습니다. 오늘 소개할 소식은 첨단 제조 강국 일본의 움직임입니다. 최근 일본의 FANUC, Komatsu, Musashi Seimitsu, Kawada Technologies가 Jetson AGX Xavier 기반의 차세대 자동화 로봇으로 디지털 기술과 AI 기반 제조 혁신을 가속화할 것이라고 발표했습니다. Jetson AGX Xavier를 탑재한 로봇은 내부에 엄청난 성능의 워크스테이션을 내장한 것과 같습니다. 최대 32 TOPs(trillion operations per second) 컴퓨팅 파워를 로봇 팔이 내장하고 있다고 보면 됩니다. Jetson AGX Xavier는 에너지 효율도 높아서 로봇에 내장하기 매우 적합합니다. Jetson AGX Xavier는 제조사가 공정에 맞는 로봇을 맞춤형으로 제작하기 편리합니다. 소프트웨어 스택을 사전에 최적화된 형태로 제공하기 때문입니다. 제조사는 최신 버전의 CUDA, cuDNN, TensorRT가 적용된 NVIDIA JetPack SDK로 AI 기반 제조 로봇을 만들 수 있습니다. Jetson AGX Xavier 개발자 키트도 제공되는 데 NVIDIA 개발자 프로그램에 가입한 경우 2,499달러의 정가에서 대폭 할인이 들어간 1,299달러에 구매해 사용할 수 있습니다. 한국도 4차 산업 혁명 시대 제조 혁신을 준비하는 기업들이 AI 기반 로봇에 관심이 많은데 곧 좋은 소식 들릴 것이라 기대해 봅니다. #NVIDIA #Xavier #Industry4 #Jetson #NVIDIA_Jetpack #제조_로봇

- 한정판 운동 수집가를 위한 특별한 서비스, GOAT ~ AI가 짝퉁 여부를 가려준다!

운동화 수집, 낯설지 않은 취미죠. 유명 연예인의 취미가 운동화 수집이란 기사가 흔하게 보일 정도입니다. 운동화 수집가의 아드레날린을 분출하게 만드는 것은 뭐니 해도 구하기 어려운 한정판을 손에 넣었을 때입니다. 한정판을 갖고 있는 사람을 찾아, 원하는 운동화를 손에 넣기까지 가장 신경이 많이 쓰이는 것은? 뭐니 해도 "이거 혹시 짝퉁 아닐까?"하는 의구심이죠. 고가 운동화 거래를 자주하다 보면 나름 짝퉁을 구분하는 나름의 노하우가 쌓이죠. 이런 수집가에게 짝퉁 구분을 의뢰하는 이들이 많아지면 이 수집가는 운동화 수집가 사이에 '네임드' 인사가 됩니다. 이처럼 한정판같이 귀한 운동화는 구하기도 어렵지만, 짝퉁도 많아 늘 수집가의 마음을 졸이게 하죠. 그래 우리가 이 문제를 한번 해결해 보자! 이런 마음에 등장한 스타트업이 있습니다. 2015년에 설립된 GOAT란 업체인데요, 이 업체는 운동화 판매자와 구매자 사이에서 짝퉁 여부를 가려주는 역할을 합니다. 판매자와 구매자는 GOAT 앱을 통해 운동화를 사고팔 수 있습니다. GOAT가 하는 일은 판매자가 올린 운동화의 짝퉁 여부를 판별한 다음, 진짜인 경우 인증을 해주는 것이죠. 구매자는 GOAT의 보장을 믿고 운동화를 사면 됩니다. GOAT에는 짝퉁 감별사가 있는 게 아닙니다. GOAT에는 400명이 근무하는 데 이중 60명의 데이터 과학자가 인공 지능(AI)을 이용해 짝퉁을 가려냅니다. GOAT는 AWS 상에서 NVIDIA Tesla GPU를 사용해 딥러닝을 수행합니다. cu-DNN 가속 기반 PyTorch 딥러닝 프레임워크를 통해 진짜로 판명된 운동화 75,000장의 이미지를 가지고 트레이닝을 하였다고 하네요. 이 과정에서 수집하는 데이터 포인트는 색상, 밑창 소재, 직물, 바느질 등입니다. 사람의 경험과 직관이 아직은 짝퉁 감별에서 한 수 위일 것 같긴 하지만 트레이닝과 추론을 거듭하면서 더 많은 데이터 세트를 접할 경우 AI가 더 나은 전문성을 보일 가능성이 큽니다. 머지않아 사람이 하던 감별 작업을 대신할 날도 멀지 않아 보여 씁쓸하네요. #GOAT #운동화수집 #cuDNN #PyTorch #AWS #NVIDIA #GPU

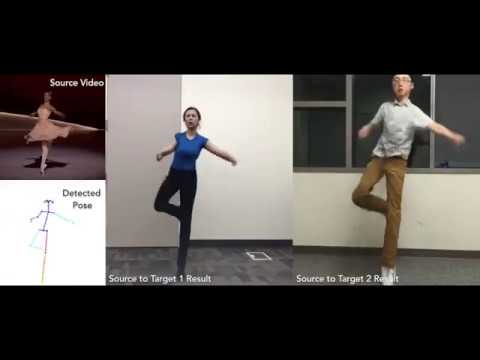

- 몸치를 전문 댄서로 만들어 주는 인공 지능 ~ 누구나 브루노 마스처럼 스웩 넘치는 힙합 춤을 출 수 있다!

춤을 잘 추는 모습, 멋지죠. 흔히 어떤 춤을 춰도 무엇인가 어색한 느낌이 드는 이들을 '몸치'라고 부릅니다. 몸치들은 혼자 있을 때 빼고는 춤을 잘 안 추게 됩니다. 웃음 참느라 주변 사람들 힘들어하는 모습도 보기 싫고, 몸치란 사실을 스스로 다시 확인하기도 싫죠. 이런 분들을 위한 인공 지능 기술이 있습니다. 버클리 대학의 한 연구팀이 딥러닝 기반 알고리즘을 하나 만들었습니다. 이 알고리즘은 누구나 프로 댄서 수준의 춤을 추는 모습으로 바꾸어 줍니다. 위 영상에서 Source 부분은 전문 댄서가 춤을 추는 화면이고, Target 부분은 일반인이 댄서의 움직임을 따라서 막춤을 추는 장면입니다. 가만 보면 소스와 타깃 화면 모두 춤을 잘 추는 것처럼 보입니다. 여기에 딥러닝의 마술이 숨어 있습니다. 브루노 마스 뮤직비디오에 나온 춤을 대충 따라 춰도, 브루노 마스처럼 스웩 넘치는 느낌을 뿜어내는 영상을 만들 수 있습니다. 버클리 대학 연구팀이 개발한 알고리즘은 전문 댄서의 포즈를 탐지하고, 이를 타깃 화면의 등장인물에 매핑하여 실제 타깃 화면의 아마추어가 춤추는 것처럼 보여주는 마술을 보여 줍니다. 샘플 영상을 자세히 보면 약간 어색한 부분도 있긴 한데, 처음 언뜻 보면 소스와 타깃 영상의 등장인물 모두 춤을 참 잘 춘다는 인상을 받습니다. 다음 영상처럼 음악까지 곁들여서 보면 더욱 구분하기 어렵습니다. 연구팀은 NVIDIA TITAN Xp, GeForce GTX 1080 Ti GPU 기반 시스템과 cu-DNN 가속 기반 PyTorch 딥러닝 프레임워크 환경에서 모델을 개발하고 트레이닝을 하였습니다. 이 팀이 트레이닝 과정에서 뽑아내는 것은 프로 댄서의 포즈입니다. 이를 위해 OpenPose를 사용해 손짓과 몸짓 등을 잡아내었다고 합니다. 그리고 이미지 전환을 위해 NVIDIA에서 개발한 pix2pixHD 아키텍처 기반의 알고리즘을 적용했다고 하네요. 이번 연구에 대한 상세 내용은 논문에 잘 나와 있으니, 관심 있는 분은 읽어 보기 바랍니다. #NVIDIA #TITAN_Xp #GeForce #GPU #cuDNN #OpenPose #PyTorch

- 인공 지능이 디자인하고, 사람이 설계하고 만드는 20세기 모던 디자인 '의자'

20세기 모더니즘 디자인을 담은 의자, 유명 작가가 디자인한 의자를 보면 지금 봐도 뭔가 독특한 느낌이 듭니다. 작가들의 작품은 사실 대량 생산을 염두에 둔 것이 아니죠. 산고의 고통을 거쳐 하나하나 빗어 내는 작품입니다. 이런 작품 하나씩 거실에 두고 싶지 않은 사람이 어디 있겠습니까? 어느 집을 가나 비슷한 느낌의 소파나 리클라이너 대신 20세기 모던 디자인 철학을 담은 의자로 분위기를 내면? 누가 와도 "이거 뭐야?" 이런 말을 할 것입니다. 인공 지능은 별일을 다 합니다. 두 명의 호기심 많은 개발자가 최근 'chAIr Project'를 진행한다고 발표했는데요, 의자를 뜻하는 chair 단어에서 인공 지능을 시각적으로 보여주는 AI 부문만 대문자로 쓰니 그럴듯해 보이네요. 체어 프로젝트는 내용은 대단한 것은 없지만! 시도에 담긴 의도는 대단히 중요해 보입니다. . 흔히 인공 지능이 사람의 일 자리를 뺏을 것이라고 이야기들 하죠. 관련해 석학들은 인공 지능과 사람이 함께 일하는 '협력'에 대한 희망적인 전망을 내놓고 있습니다. 체어 프로젝트는 인공 지능과 가구 전문가의 협업에 대한 시도란 점에서 흥미롭습니다. 체어 프로젝트는 유명 가구 디자이너의 작품을 데이터 세트로 사용해 GAN(Generative Neural Network)에서 딥러닝 기반 트레이닝을 하는 것에서 출발합니다. 트레이닝을 거친 모델은 20세기 모던 디자인 스타일을 따르는 의자 스케치를 그려 냅니다. 이를 참조해 사람이 직접 디자인을 하고, 이를 가구 장인이 실제 앉을 수 있는 의자로 만듭니다. 트레이닝을 위해 사용된 데이터는 562개의 모던 디자인 의자 사진인데요, 핀터레스트에서 구했다고 합니다. 두 개발자가 만든 딥러닝 모델은 학습을 통해 다음과 같이 추상적인 특징을 뽑아내어 의자를 스케치합니다. 체어 프로젝트는 NVIDIA GeForce GTX 1080 TI GPU와 cu-DNN 가속 기반 PyTorch 딥러닝 프레임워크 환경에서 모델 개발과 트레이닝이 이루어졌습니다. 요즘 동네마다 가구 공방이 생기는 분위기인데, 이들 공방에서 GPU 시스템 한대 두고 맞춤형 가구 디자인과 제작을 하면 인기 좀 끌 것 같네요.

- 동물의 움직임을 자동으로 추적하고 라벨을 붙이는 딥러닝 모델 ~ 물리 치료, 스포츠 과학 등에 두루 쓰이기 좋은 접근

#해시태그 사용이 익숙하신가요? 하버드 대학 연구팀이 딥러닝 기반으로 동물의 움직임을 자동으로 추적하고 라벨을 붙이는 방법에 대한 논문을 발표했습니다. 이 방법에 붙인 이름은 'DeepLabCut'입니다. 비디오 영상을 보고 동물의 행동을 관찰하고 기록하는 것은 컴퓨터 비전 알고리즘을 통해 구현하면 아무래도 복잡하죠. #DeepLabCut을 이용하면 매우 간단해집니다. 그렇다면 동물의 움직임을 추적해서 뭘 할 것이냐? 응용 분야는 무궁무진합니다. 몇 가지만 예를 들어 보겠습니다. ▶ 스포츠: 스포츠 과학에서 선수의 움직임을 추적하고, 기록하고, 분석하는 것은 매우 중요합니다. 이는 비단 사람에게만 해당하지 않습니다. 경마 등 동물이 스포츠 경기의 주체인 경우도 스포츠 과학이 요긴하게 쓰일 수 있습니다. DeepLabCut은 선수 분석이나 경기력 향상 등에 이용할 수 있습니다. ▶ 로봇: 제조나 서비스 로봇의 움직임을 추적하다 보면 로봇의 오작동이나 이상 유무를 판단할 수 있죠. ▶ 의료: 물리 치료를 떠올려 보면 그냥 DeepLabCut의 응용 방식이 떠오를 것입니다. ▶ 의학 연구: 박테리아, 실험동물 등 움직이는 것이 연구 대상이라면 DeepLabCut은 육안 검사의 불편을 한 번에 날려 줄 수 있는 유용한 도구가 됩니다. DeepLabCut의 코드는 깃허브에 올라와 있으며, 상세 내용은 논문을 통해 읽어 볼 수 있습니다. 참고로 이 모델은 #NVIDIA #GeForce GTX 1080 Ti와 NVIDIA TITAN Xp #GPU 기반 시스템을 이용해 개발과 트레이닝이 이루어졌습니다. 연구팀은 #cu-DNN 가속 기반 #TensorFlow 딥러닝 프레임워크를 사용했고 데이터 세트는 이미지넷에서 가져와 썼다고 합니다. 원리는 다음과 같이 간단합니다. 영상에서 특정 프레임을 추출하고, 라벨을 붙이고, 트레이닝을 하는 것입니다. 이 연구의 핵심은 복잡하고 어려운 작업을 딥러닝 모델을 통해 간소화했다는 것이고, 그 응용 분야가 매우 다양하다는 것입니다. 최소한의 데이터 세트를 사용했고, 추론 작업 부담도 크지 않다는 특징을 고려할 때 모바일 앱으로 나와도 재미있을 듯합니다.

- 야마하 모터가 NVIDIA Jetson AGX Xavier로 하고자 하는 것은?

야마하 모터가 NVIDIA의 Jetson AGX Xavier를 도입합니다. 이것으로 무엇을 하려는 것일까요? 야마하 모터의 차세대 제품군에 핵심으로 쓰일 전망입니다. 야하마 모터는 농기계, 보트, 운송 수단 등의 제조에 Jetson AGX Xavier를 적용할 계획입니다. 야마하 모터가 다양한 탈것에 AI라는 새로움을 더하려는 것은 '자율 주행'을 위해서입니다. 자동차만 자율 주행을 목표로 기술 개발을 하는 게 아니에요. 농장이나 거리, 강과 바다에서 사람과 짐을 실어 나르는 탈것도 자율 주행을 꿈꾸고 있습니다. 야마하는 Jetson AGX Xavier를 통해 자율 주행 관련해 일종의 표준화된 자사의 플랫폼 기준을 잡을 계획입니다. 자동차가 플랫폼 공유로 원가 절감과 신제품 출시 속도를 높이는 것과 유사한 접근이죠. AI 기반 자율 주행 플랫폼을 공유해 다양한 제품에 적용하려는 것입니다. 현재 야마하 모터가 AI 기반 자율 주행 기능을 우선 접목할 분야는 농업 쪽이 될 것으로 보입니다. 농작물을 키우기 위해 트랙터 등 다양한 농기계가 쓰이는데 이들 기계가 자율 주행을 한다고 생각해 보십시오. 그리고 거대한 농지에 농약을 뿌리는 일을 드론이 알아서 해준다고 상상해 보십시오. 4차 산업 시대 농업의 미래가 바로 이 모습이지 않을까요? AI에 대한 이런 투자, 특히 농업 분야에서 쓰이는 각종 탈것과 장치에 자율 주행을 더하려는 노력은 고령화라는 피할 수 없는 사회 현상을 극복하려는 일본 정부와 산업계의 의지가 담겨 있습니다. 일본의 경우도 고령화로 인해 농업에 종사하는 인력이 2010년까지 30% 이상 줄어들 것이라고 합니다. 일손은 줄어들지만 농작물에 대한 수요는 줄지 않죠. 그렇다면 대안은? 수입을 무작정 늘릴 수도 없습니다. 식량 주권과 안보의 중요성은 생각보다 큽니다. 일본의 선택은 농업의 자동화 수준을 높이는 것이고, 이를 위해 야마하 모터 같은 기업이 AI를 통해 혁신을 주도하는 것, 이것이 바로 2018년 현재 일본 농업의 미래가 아닐까 합니다. #NVIDIA #Jetson #Xavier #AI #야마하모터 #제조_로봇